Methoden des maschinellen Lernens erobern unseren Alltag. Sie glänzen in Brettspielen, lernen Auto fahren, sagen komplizierte Proteinfaltstrukturen voraus und können sogar ganze Texte übersetzen. All dies kann von großem Nutzen sein – aber nicht nur. Algorithmen entscheiden auch über Kreditvergabe, ob man zum Vorstellungsgespräch eingeladen wird und in allerlei anderen Situationen, bei denen Bewertungen im Spiel sind. Das wirft nicht nur technische Fragen auf – welcher Algorithmus funktioniert besser? – sondern auch gesellschaftliche: Welche Algorithmen wollen wir, unter welchen Umständen, wofür verwenden?

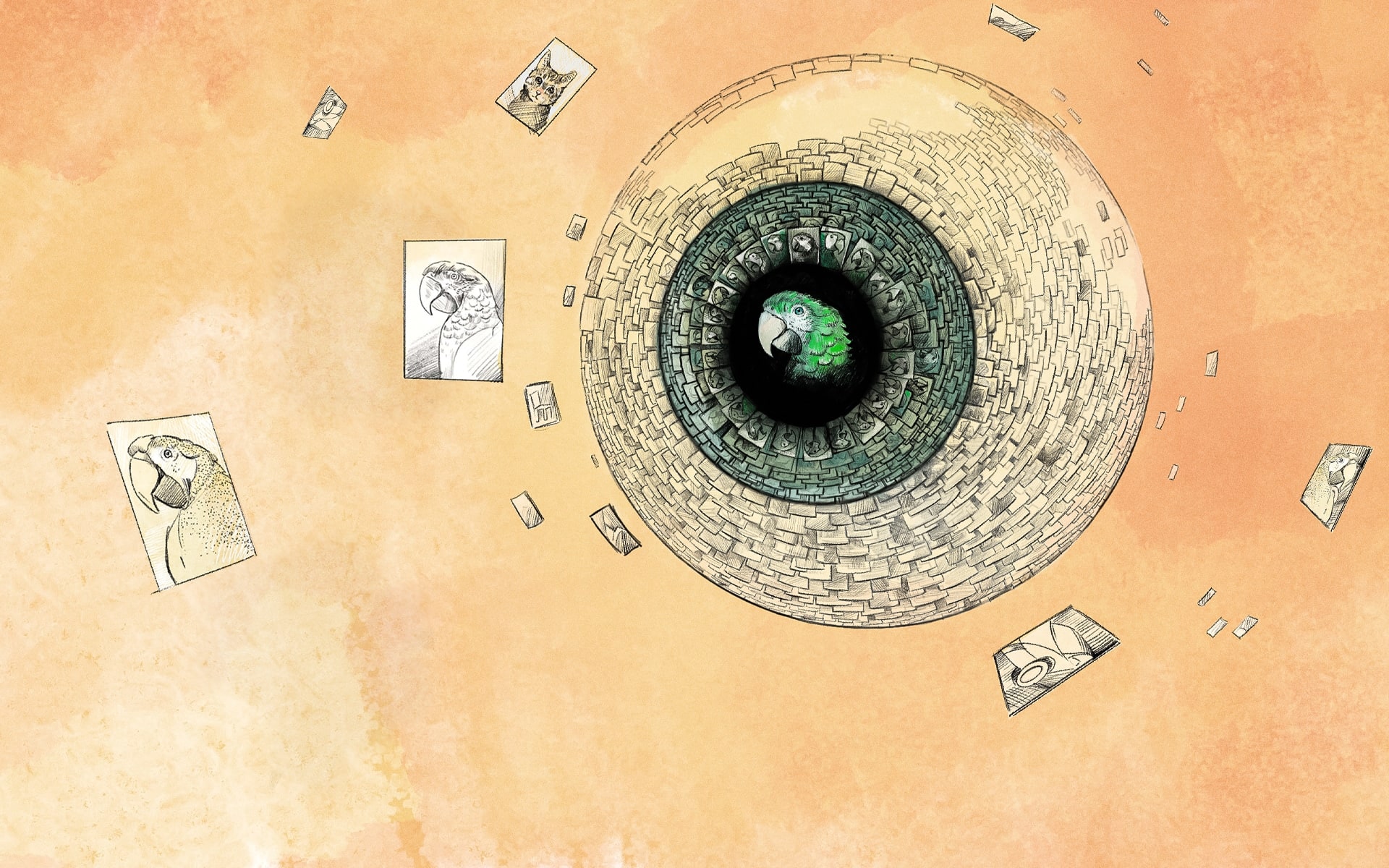

Denn die verblüffende Effizienz der Methoden des maschinellen Lernens hat auch ihre Gegenseite: Fragen, Fragen und noch mehr Fragen. Was bedeuten die Vorhersagen der Algorithmen, und aus welchen Gründen wurden sie getroffen? Sind sie fair, unvoreingenommen, und nahe an der Wahrheit? Wenn mir die Bank sagt: „Sie bekommen den Kredit nicht“, fühle ich mich im Recht zu fragen: „Warum denn nicht?“. Ich erwarte, dass die Bank die mich betreffende Entscheidung rechtfertigt, mir ihre Urteilsfindung darlegt, so dass ich meinen Antrag in Zukunft verbessern kann oder mein Glück anderswo versuche. Können wir Ähnliches von den Algorithmen erwarten? Sollen auch sie sich uns erklären? Solche Forderungen gehen in das kürzlich entstandene Forschungsfeld der Erklärbaren Künstlichen Intelligenz (kurz KI) ein, welches versucht, die Entscheidungen komplizierter Algorithmen für Menschen verständlicher zu machen, durch zusätzlich erzeugte Erklärungen.

Doch was kann man sich von der Forderung nach Erklärung eigentlich erhoffen, und wird erklärbare KI unseren Erwartungen gerecht? In der EU hat diese Frage aktuelle Brisanz: Erst kürzlich hat die Europäische Kommission einen Entwurf des „Artificial Intelligence Act“ vorgelegt. Dieses Gesetz würde die Anforderungen an künstliche Intelligenz in der gesamten EU festlegen. Welche Rolle kann und soll erklärbare KI darin einnehmen? In unserem kürzlich auf der FAccT-Konferenz veröffentlichten Artikel beleuchten wir diese Frage aus drei verschiedenen Perspektiven: dem maschinellen Lernen, der Rechtswissenschaft und der Philosophie.

Die gesellschaftliche Relevanz nicht-kooperativer Situationen

Als erstes fiel uns auf, dass wir bei gesellschaftlichen Anwendungen des maschinellen Lernens zwischen zwei fundamental verschiedenen Situationen unterscheiden müssen. In kooperativen Situationen, wie wissenschaftlichen Anwendungen und Textübersetzungen, sind die Interessen des Betreibers und des Nutzers der KI ungefähr dieselben. Der Programmierer, die Ärztin und der Patient wünschen sich alle drei einen Algorithmus, der Krebs frühzeitig akkurat erkennt und plausible Gründe dafür darlegt. In nicht-kooperativen Situationen hingegen stehen die Interessen des Betreibers der KI denen des Datensubjekts entgegen. Der Darlehensnehmer will einen möglichst hohen Kredit mit wenig Zinsen, wohingegen für die Bank ihre eigene Gewinnmaximierung im Vordergrund steht und nicht etwa die Transparenz des Vergabeprozesses. Nicht-kooperative Situationen sind aber gerade die gesellschaftlich relevanten, denn hier müssen wir als Gesellschaft zwischen verschiedenen Interessen wie denen einer Bank und ihren Kunden abwägen und nach Möglichkeit ein Gleichgewicht herstellen.

Als zweites bemerkten wir, dass die derzeitige Rechtsgrundlage für Erklärbare KI relativ vage bleibt. Zumindest gibt es derzeit keine Basis, aufgrund der man sagen könnte: Von einer erklärbaren KI erwarten wir x, y, z, und wenn sie das nicht kann, ist sie in der Situation s verboten. Diese begriffliche Klarheit muss erst noch geschaffen werden. In nicht-kooperativen Situationen zum Beispiel soll die Erklärung dem Erklärungsempfänger helfen etwas zu tun, z.B. Einspruch zu erheben oder sich zu verbessern. Das setzt jedoch voraus, dass die Erklärung wahr ist. Denn falsche Erklärungen könnten unser Handeln fehlleiten.

Erklärungen sollen nicht zum Deckmantel für Täuschungen werden

In unserem Artikel argumentieren wir vor diesem Hintergrund, dass derzeit existierende Erklärungsalgorithmen in nicht-kooperativen Situation unseren Erwartungen nicht gerecht werden können. Das liegt vor allem daran, dass es für eine Entscheidung eines komplizierten KI-Systems viele plausible Erklärungen gibt, aber keine eindeutig richtige. In bestimmten Fällen mag es möglich sein, die Entscheidungen eines KI-Systems mit einfachen Mitteln zu erklären. Im Allgemeinen bleiben Entscheidungen eines komplizierten Systems allerdings vor allem eins: kompliziert. Unseren Durst nach Wahrheit bzw. eindeutig richtigen Antworten können vereinfachende Erklärungen daher auf keinen Fall löschen.

Während Erklärungen in kooperativen Situationen nützliche Einblicke in die Funktionsweise der KI geben mögen, kann eine Erklärung in nicht-kooperativen Situationen auch unerwünschte Folgen haben. Tatsächlich zeigen wir, dass derzeitige KI-Erklärungen von vielen spezifischen Details des KI-Systems abhängen: den Trainingsdaten, der genauen Form der Entscheidungsoberfläche, der Wahl dieses oder jenes Erklärungsalgorithmus, und so weiter. Da die Entwicklerin oder der Entwickler der KI diese Parameter in der Regel frei wählen kann, besteht die Gefahr, dass die Erklärung zwar informativ und plausibel erscheint, letztendlich aber vor allem dem Zweck dient, die KI und ihren Entwickler unangreifbar zu machen. Der Entwickler der KI hat schlicht kein Interesse daran, solche Erklärungen auszuwählen, die kritische Aspekte des KI-Systems hervorheben würden. In einem nicht-kooperativen Szenario helfen uns die algorithmischen Erklärungen darum leider nicht weiter, sie mögen uns gar in die Irre leiten. Auch zeigen wir, dass es nicht viel Sinn ergibt, Erklärungsalgorithmen auf ihre Richtigkeit zu testen. Im besten Fall können wir interne Konsistenz (zwischen Erklärung und Vorhersage), also eine Art schwacher “Aufrichtigkeit” testen, aber subtilere Täuschungsmanöver bleiben damit unentdeckt.

Die Probleme von algorithmischen Erklärungen bedeuten jedoch nicht, dass wir dem KI-System hilflos gegenüberstehen: In unserem Artikel diskutieren wir verschiedene Szenarien, unter denen eine KI getestet werden kann. Dabei müssen wir uns als Gesellschaft zuerst einig werden, was wir von der KI eigentlich erwarten. Nur auf einer solchen Basis kann entschieden werden, ob dieser Algorithmus erlaubt und jener andere verboten werden sollte. Statt uns auf Erklärungen als Allheilmittel zu verlassen, sollten wir nach anderen Methoden suchen, die uns auch das liefern, was wir uns mit unserer ursprünglichen Frage nach einer Erklärung erhofften. Eine Möglichkeit bieten hierbei die von Grund auf interpretierbaren Algorithmen. Aber das ist eine andere Geschichte …

KI-Systeme, die ihre Entscheidungen erklären

Kommentare