Viele KI-Systeme gelten als „Black Boxes“. Undurchsichtige Systeme, deren Entscheidungsmechanismen nicht einsehbar sind. Aber wie wäre es, wenn wir mit dem System in Austausch treten, fast schon ein kleines Gespräch mit ihm führen könnten? Wenn wir ihm zu den Ergebnissen, die es liefert, Fragen stellen könnten – und es uns dann erklären würde, warum es so entschieden hat?

Was fast wie ein fantastisches Gedankenspiel klingt, ist bereits seit einigen Jahren Gegenstand von Zeynep Akatas Forschung. „Über Erklärbarkeit aus der Perspektive des Users nachzudenken, ist dringend notwendig“, sagt Akata, 35, Professorin für erklärbares maschinelles Lernen an der Universität Tübingen. „Menschen können Beziehungen zu Maschinen aufbauen.“ In ihrer Forschung befasst sie sich mit verschiedenen Facetten von Erklärbarkeit – also der Fähigkeit einer lernenden Maschine, ihre Entscheidungen zu begründen. Letztendlich geht es darum, den Nutzerinnen und Nutzern Einblicke in die Entscheidungsprozesse zu geben und so ihr Vertrauen in die Maschine zu stärken.

Akata möchte Einblicke in die Entscheidungsprozesse von KI-Systemen geben. © SOPHIA CARRARA/UNIVERSITÄT TÜBINGEN

Nicht nur in der Forschung hat Erklärbarkeit in den vergangenen Jahren an Bedeutung gewonnen. Auch die Politik hat das Thema entdeckt und auf ihre Agenda gesetzt. So wird etwa die EU-Datenschutzgrundverordnung von 2018 so interpretiert, dass sie mit Blick auf automatisierte Entscheidungen „ein Recht auf Erklärungen“ einführt. Wenn eine Entscheidung automatisiert getroffen wird, muss die betroffene Person aussagekräftige Informationen darüber erhalten können, auf welcher Logik das System beruht. Und erst in diesem Frühjahr forderte die Europäische Union in einem Whitepaper, dass KI-Systeme künftig transparenter sein und ihre Entscheidungswege offenlegen müssten.

Aufmerksamkeitskarten zeigen, auf welchen Bildbereich das System sich konzentriert

Aber wie genau funktioniert das, ein System erklärbar machen? Zeynep Akata schildert es anhand von KI-Systemen, die Bilder erkennen und klassifizieren. Diese Systeme basieren auf Deep Learning, arbeiten also mit künstlichen, tiefen neuronalen Netzen, die dem menschlichen Gehirn nachempfunden und ähnlich schwer zu entschlüsseln sind.

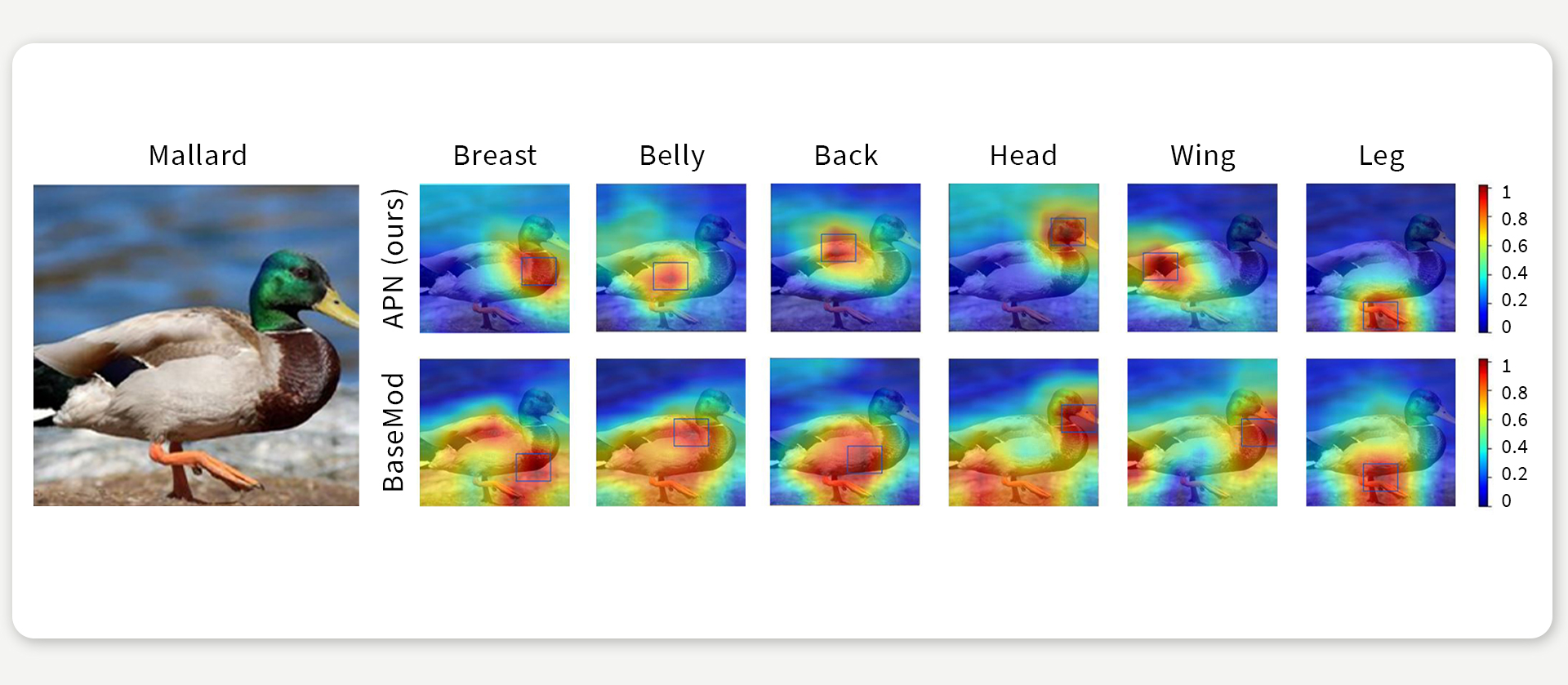

„Im Prinzip gibt es zwei Kategorien der Erklärbarkeit“, sagt Akata. „Die eine ist der Blick ins System hinein, Introspektion genannt, und die andere die rechtfertigende Erklärung.“ Den Blick ins Innere des Systems müsse man sich so vorstellen, als wenn man den Kopf eines Menschen öffne, um hineinzuschauen und zu sehen, welche Neuronen bei einem bestimmten Denkprozess aktiviert sind. So einfach geht das natürlich nicht, weder beim Menschen noch bei der Maschine, also sucht man andere Wege, zum Beispiel mit einer sogenannten Aufmerksamkeitskarte. Das System kennzeichnet darin mit Farben, auf welchen Teil es wie viel Aufmerksamkeit gerichtet hat. Rot steht dann zum Beispiel für die einflussreichste Region, dann folgt orange, dann gelb und so weiter. So weiß der Mensch, auf welche Teile des Bildes die Maschine sich wie stark konzentriert hat. Er kann weitestgehend nachvollziehen, wie sie vorgegangen ist. Das gibt ihm nicht zuletzt die Möglichkeit, Fehler im Vorgehen der Maschine zu erkennen und nachzuvollziehen, warum sie falsche Ergebnisse liefert.

Aufmerksamkeitskarten erlauben einen Blick ins Innere des Systems. Hier sollten zwei verschiedene Algorithmen in einem Bild die Körperteile einer Stockente bestimmen. Die Aufmerksamkeitskarten verdeutlichen, dass der eine Algorithmus (APN, entwickelt von Akata und Kollegen, obere Bildreihe) die entscheidende Bildregion in allen Fällen treffsicher erkannt hat und die Körperteile dementsprechend präziser vorhersagt als der andere Algorithmus (BaseMod, untere Bildreihe). Abbildung nach Xu et al, 2020.

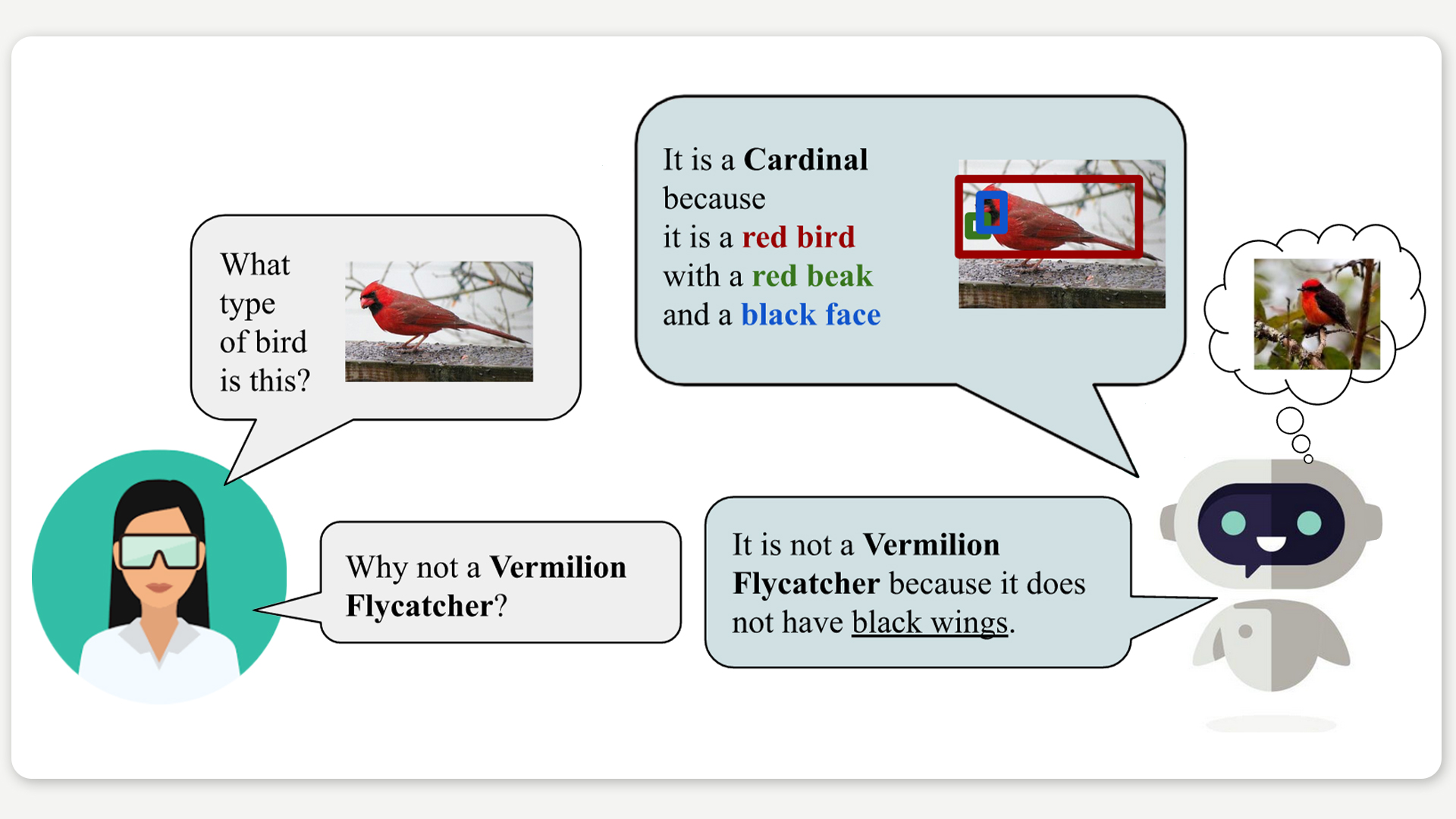

Die zweite Kategorie, die rechtfertigenden Erklärung, erläutert Akata am Beispiel eines Systems, dem der User Fragen zu einem Bild stellen kann, etwa: „Was für eine Vogelart ist das?“. Das System sollte dann nicht nur die klassenspezifischen Eigenschaften nennen – etwa den roten Körper, das schwarze Gesicht und den roten Schnabel – sondern diese auch innerhalb des Bildes kennzeichnen, indem es sie jeweils mit einer Box umrandet. Das Besondere an Akatas Arbeiten: Das System kann seine Antworten sogar in menschlicher Sprache liefern. Seine Antwort auf die Frage nach der Vogelart: „Das ist ein Kardinal, da es ein roter Vogel mit einem roten Schnabel und einem schwarzen Gesicht ist.“

Akata forscht zu KI-Systemen, die ihre Entscheidungen in menschlicher Sprache erklären können. Sogar eine kleine Unterhaltung zwischen Nutzerin und System wird so möglich. Abbildung nach Hendricks et al., 2018.

Erklärbarkeit kann Mensch und Maschine näher zusammenbringen

Von der Black Box zu einem System, dem man Fragen stellen kann – eine Entwicklung, die das Potenzial hat, das Vertrauen von Menschen in KI-Systeme entscheidend zu erhöhen. „Das kommt unserer menschlichen Kommunikation am nächsten“, betont Akata. Das System muss schlüssige Aussagen machen, die sich nicht gegenseitig widersprechen, und es muss auf die korrekten Attribute im Bild hinweisen. „Es ist wie eine Zeugenbefragung vor Gericht, wenn man herausfinden möchte, ob die Aussagen eines Zeugen stimmig und überzeugend sind.“

Dieser Vergleich macht deutlich, worum es Akata in ihrer Forschung geht: Nicht nur technische Prozesse offenlegen, sondern auch dem Menschen als Nutzer von Technologie eine neue Handlungsfähigkeit ermöglichen.

Die Verbindung von Erklärbarkeit und natürlicher Sprache hat Akata fasziniert, seit sie in der Forschung Thema wurde. Das war etwa um 2015, zu ihrer Zeit als Postdoc am Max-Planck-Institut für Informatik in Saarbrücken. Sie forschte am Lehrstuhl von Bernt Schiele im Bereich Computer Vision und arbeitete zu Systemen, die Merkmale in Bildern vorhersagen, also erkennen und bestimmen können. „Wir verwendeten die Merkmale als Mittel, unsere Klassifizierungsmodelle zu verbessern, aber sie können auch als Mittel zur Erklärung verwendet werden. Ich wollte also Daten sammeln und einen Schritt weiter gehen und sprachliche Erklärungen erstellen“, erzählt sie. Der Pionier auf diesem Feld, Trevor Darrell, war Professor an der University of California in Berkeley, sie kannte ihn nicht persönlich. Doch als sie ihn zufällig auf einer großen Konferenz sah, wie er in einer Pause dastand und etwas auf seinem Handy las, sprach sie ihn an. „Ich sagte zu ihm: ‚Ich habe einen Datensatz und eine Idee, ich brauche Ihre Unterstützung‘. Er schaute von seinem Handy auf und kuckte mich an, als wollte er sagen: ‚Wer sind Sie?‘“ Akata lacht, als sie die Geschichte erzählt, als ob sie den erstaunten Blick des Mannes noch genau vor sich habe. Doch ihre Entschlossenheit, auf Darrell einfach zuzugehen, wurde belohnt.

Eine Zufallsbegegnung mit Folgen

Erklärbarkeit hat das Potenzial, das Vertrauen in KI-Systeme zu stärken. © SOPHIA CARRARA/UNIVERSITÄT TÜBINGEN

Rückblickend war die Zufallsbegegnung auf der Konferenz der Auftakt einer spannenden Zeit – und Akatas Einstieg ins Feld der Erklärbarkeit. Sie ging für sechs Monate nach Berkeley in Darrells Arbeitsgruppe. Auch später als Assistant Professor in Amsterdam arbeitete sie weiter mit der Gruppe zusammen und veröffentlichte Arbeiten bei namhaften Konferenzen.

Seit 2019 ist sie Professorin für erklärbares maschinelles Lernen am Exzellenzcluster „Maschinelles Lernen für die Wissenschaft“ der Universität Tübingen. Als sie die Stelle antrat, war sie erst 33 und hatte gerade ein ERC Starting Grant bekommen, den renommiertesten europäischen Förderpreis für junge Wissenschaftlerinnen und Wissenschaftler. „Man hatte mir geraten, mich noch nicht für den Grant zu bewerben“, erzählt sie. „Aber wenn man mir sagt, dass ich etwas nicht schaffen werde, motiviert mich das erst recht, es zu tun“.

Diesen Geist, an die eigenen Projekte zu glauben, und dabei im wahrsten Sinne des Wortes auch Grenzen zu überwinden, gibt Akata, die in der türkischen Universitätsstadt Edirne aufwuchs und dort, in Aachen und in Grenoble studierte, auch an ihre Gruppe weiter. Etwa ein Dutzend Doktorandinnen und Doktoranden sowie Postdocs aus verschiedenen Ländern, von Dänemark bis China, gehören zu ihrem Kernteam. Die Gruppe ist nicht zuletzt auch stark international, da Akata Teil des europäischen Netzwerks ELLIS ist und in diesem Rahmen Doktorandinnen und Doktoranden gemeinsam mit Forschenden aus anderen europäischen Universitäten oder Unternehmen betreut. Hinzu kommen außerdem einige junge Forschende anderer Universitäten, mit denen die Gruppe kooperiert.

Von Anwendungen in der Medizin bis hin zu selbstfahrenden Autos

Alle Gruppenmitglieder arbeiten zu Erklärbarkeit, aber zu ganz unterschiedlichen Aspekten. Entsprechend der Ausrichtung des Exzellenzclusters „Maschinelles Lernen für die Wissenschaft“ befassen sich einige von ihnen mit der Anwendung von KI in anderen Wissenschaftsbereichen und welche Rolle die Erklärbarkeit hier spielt, etwa in der medizinischen Bildgebung oder im Bereich Computer Vision und selbstfahrende Autos. Auch das audiovisuelle Lernen, also die Arbeit zu Erklärbarkeit bei KI-Systemen, die Muster in Tonmaterial und in bewegten Bildern erkennen, gehört zum Repertoire der Gruppe.

Ermuntert ihr Team, an die eigenen Ziele zu glauben: Zeynep Akata (links), hier im Gespräch mit ihren Postdocs Massimiliano Mancini (Mitte) und Yanbei Chen (rechts). © SOPHIA CARRARA/UNIVERSITÄT TÜBINGEN

Diese Vielfalt spiegelt wider, wie stark das Feld der Erklärbarkeit inzwischen in andere Wissenschaftsbereiche und auch in die Forschung von Industrieunternehmen ausstrahlt. Könnte die Erklärbarkeit zu einer Schlüsseldisziplin werden, die insgesamt zu mehr Transparenz von KI-Systemen führt? „Ich denke, allein der Schritt, einen Lehrstuhl an der Universität ‚Lehrstuhl für erklärbares maschinelles Lernen‘ zu nennen, war ein wichtiges Signal“, sagt Akata. „Die Forschung zu Erklärbarkeit zwingt die Wissenschaftlerinnen und Wissenschaftler dazu, über die Perspektive der User nachzudenken. Denn wir sollten versuchen, zu verstehen, warum ein bestimmtes Modell funktioniert – und wir sollten versuchen, herauszufinden, was der Grund dafür ist, wenn es nicht funktioniert.“

Mehr Informationen über die Forschung der Gruppe „Erklärbares maschinelles Lernen“ finden Sie auf ihrer Webseite. Neuigkeiten gibt es auf Twitter.

Zeynep Akata war von 2019 bis 2023 Mitglied unseres Clusters und hatte die Cluster-W3-Professur für „Erklärbares Maschinelles Lernen“ inne. Aktuell ist sie Direktorin des Instituts für Erklärbares Maschinelles Lernen am Helmholtz-Institut München sowie Professorin für Informatik an der Technischen Universität München.

Algorithmus und Mensch als Partner

Kommentare